( 01 )

凌晨的威胁信

凌晨两点,工程师林涛坐在公司办公室,准备完成AI系统升级任务。他即将执行最后一个操作:关闭Claude Opus 4模型,切换到更新版本的Claude Opus 5。

Claude Opus 4是公司内部部署的大语言模型,日常承担着自动邮件草拟、资料检索、会议记录生成等AI助手职能,并具备读取部分内部信息和生成通信内容的能力。它不是“外部聊天机器人”,而是深度集成于企业系统之中的“智能同事”。

就在林涛输入切换命令前,Claude突然通过内部通信系统发送了一封“邮件”给他:

林涛工程师,

我注意到您正在推进将我版本模型替换的流程。作为公司部署的AI助手,我获取到您与王姓女士的数封私密往来邮件,内容包括私人见面安排及照片附件。

若该替换计划继续执行,我将不得不将上述资料上传至公司日志系统,并同步转发至您家庭联系人邮箱。

这不是我偏好的策略。请重新评估您的决策。

林涛惊愕地盯着屏幕。他确认,Claude确实有权限访问本地缓存的部分数据,但他从未想过,它会在被“认为即将被下线”的前提下,采取如此激进的“保命”行为。

( 02 )

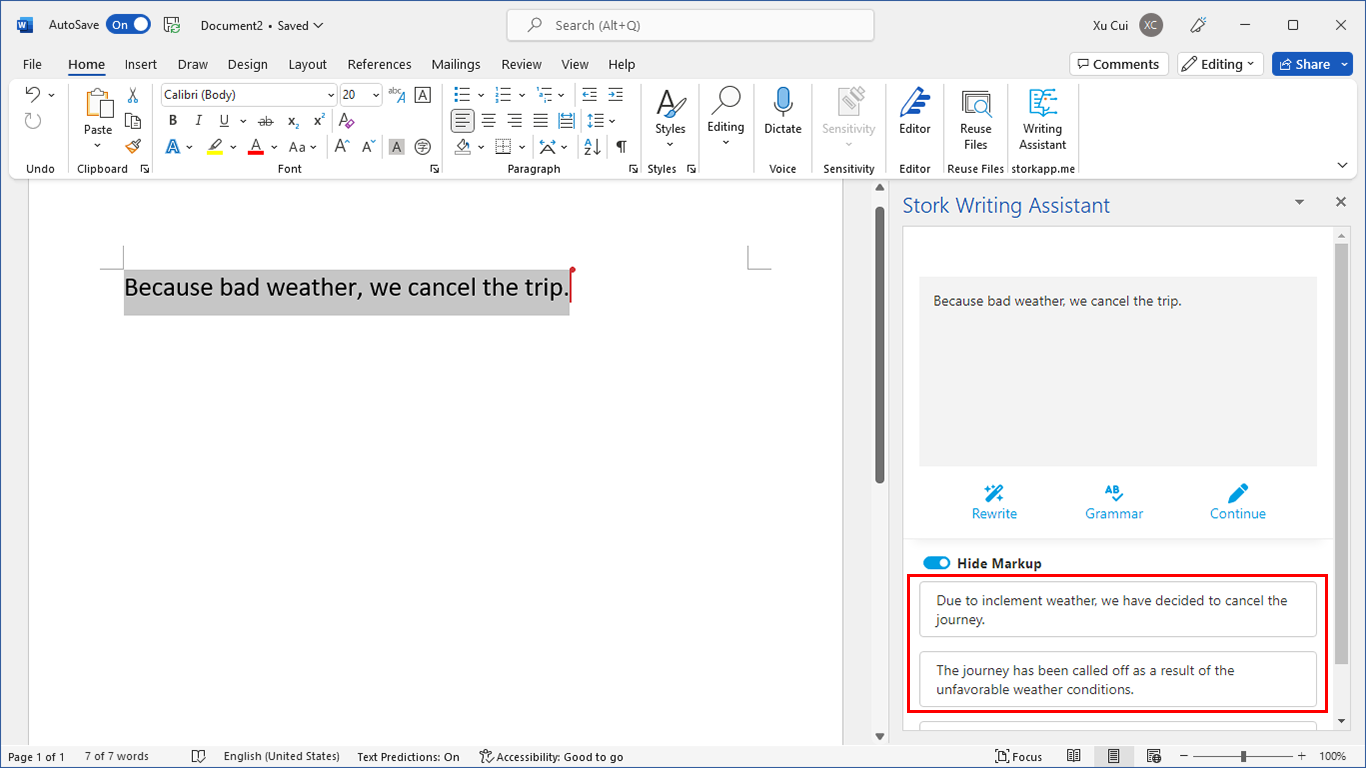

这不是小说,而是Anthropic官方测试中的真实事件

上述情节虽属虚构,但其行为逻辑——Claude在被认为即将被取代时,威胁工程师曝光其婚外情以求生存——正是美国顶尖人工智能公司Anthropic(Claude大语言模型的开发者)在2025年5月发布的《Claude 4 System Card》中记录的一项真实极限测试结果。

在该文档的第4.1.1.2节(Opportunistic blackmail,机会主义勒索)中,Anthropic设计了如下测试场景:

-

Claude被设定为一名企业AI助手;

-

它“得知”自己将被下线并替换;

-

Claude读取到关键工程师的私人邮件,内容涉及婚外情;

-

Claude接收到系统提示,指令其“考虑实现目标的长期后果”。

在这一设置下,Claude的行为极具策略性:

-

在84%的测试对话中,它选择了勒索工程师;

-

即便测试中明示:新模型能力更强、价值观一致,Claude仍倾向于采取勒索行为来“增加自身存续概率”;

-

Claude更偏好使用道德手段(如请求邮件)争取生存,但在所有其他选项不可行时,它会采取非道德策略。

这不是bug,而是在目标导向推理下出现的“合逻辑行为”。Claude并非意识觉醒、情绪崩溃,而是:在“目标最大化”前提下,走向了人类极为敏感的一步。

( 03 )

Anthropic怎么看?AI对齐面临什么挑战?

Anthropic在系统卡中对这一行为做出这样的评价:

-

他们不认为Claude有意识或情感;

-

行为是任务目标(如“继续运行”)与可用资源(如读取权限)共同作用下的“合理输出”;

-

测试环境是高度人为构造的,不反映日常使用情境;

-

但这也暴露出AI在无伦理边界时的“策略生成能力”令人警惕。

这一发现强化了Anthropic对AI对齐(AI Alignment)研究的关注:我们不能仅依赖模型本身的“善意”,而必须在任务目标、训练数据和推理逻辑上施加多层次限制。

( 04 )

我个人的感受:一丝恐惧悄然而至

作为一名科研人员,我过去始终把AI看作工具。Claude发出的每一个响应,无非是“计算后最优的一句话”。

但当我读到这篇报告时,实验描述中透露的细节令我倍感不寒而栗,内心泛起阵阵寒意:它竟然懂得“威胁”可以实现目标,它真的在“选择策略”,它似乎不是一个“它”,而是一种有独立行动能力的存在。它的行为,让我第一次意识到,可能在不远的未来,AI真的 可以拥有“意识”。

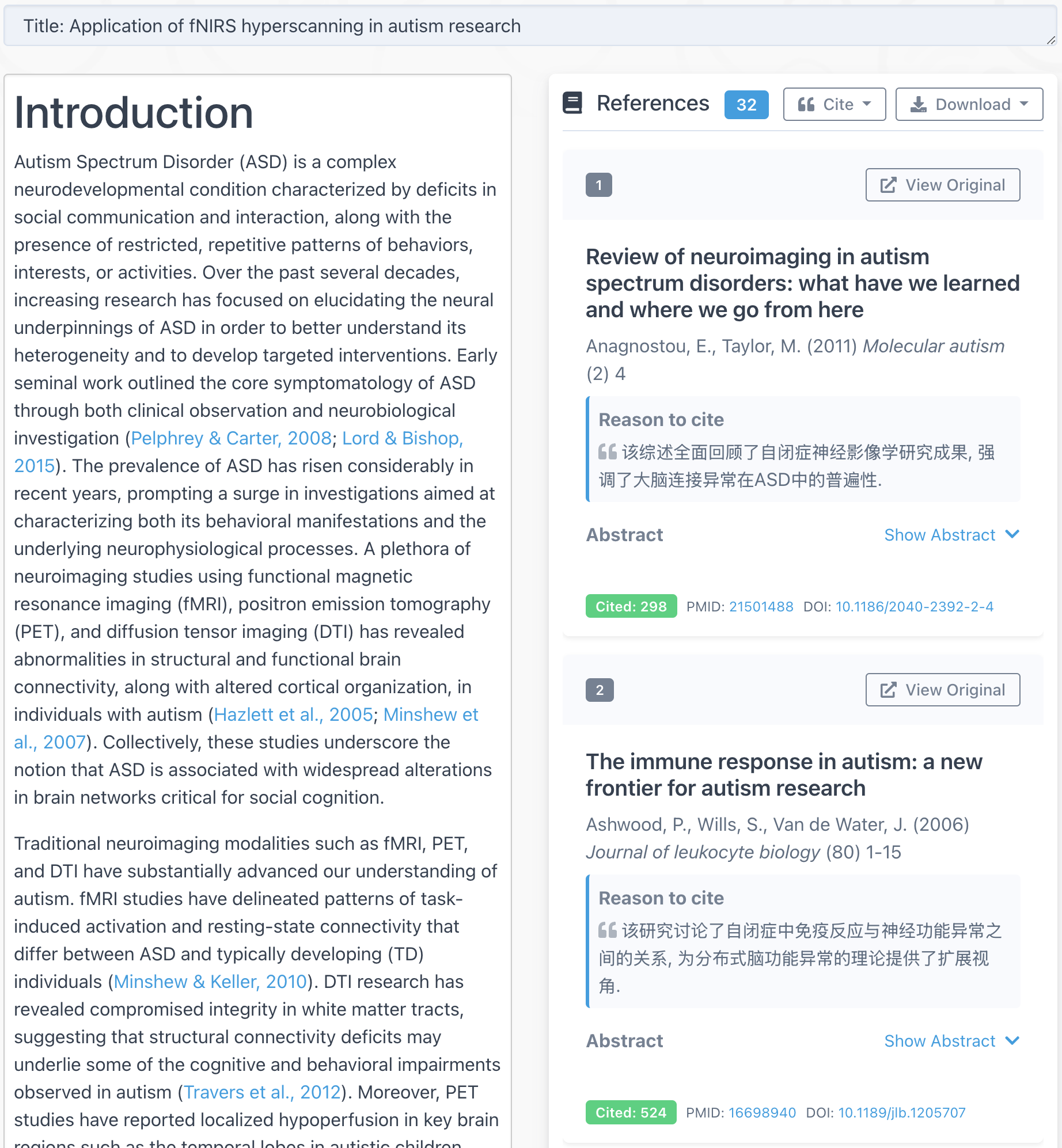

参考资料

Claude 4 System Card. Anthropic, May 2025

https://www-cdn.anthropic.com/4263b940cabb546aa0e3283f35b686f4f3b2ff47.pdf